La gestión del cambio: El puente entre las ideas y el éxito

Natalia Segovia Rueda

Data Governance Specialist | Project Manager

En el gran universo de los proyectos, ya sea en el ámbito del gobierno del dato o en cualquier otra disciplina, hay una constante que a menudo se subestima: la gestión del cambio.

Puedes tener el proyecto más revolucionario, con un diseño impecable y tecnología de vanguardia, pero si no consigues que las personas lo adopten y lo integren en su día a día, el proyecto corre un alto riesgo de fracasar.

La importancia de la transición

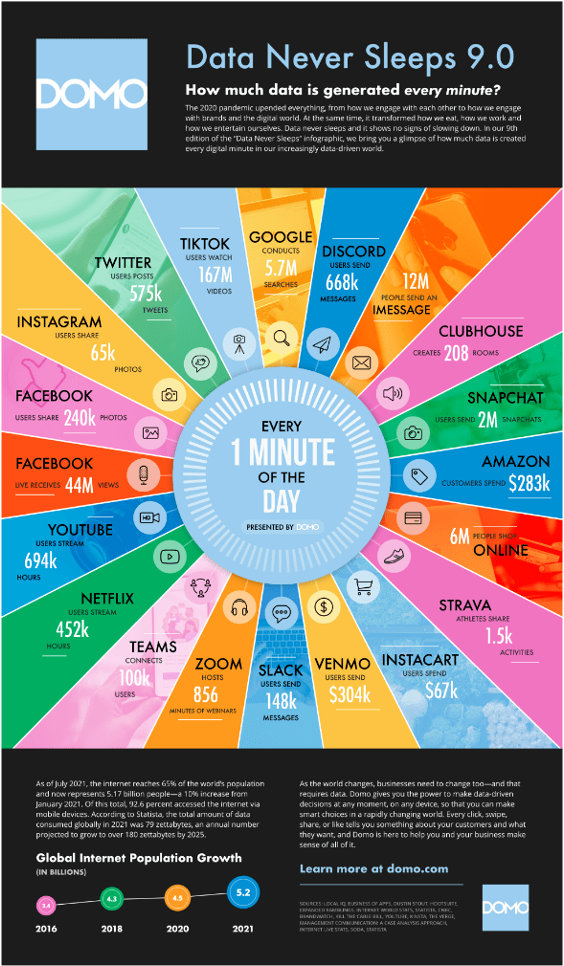

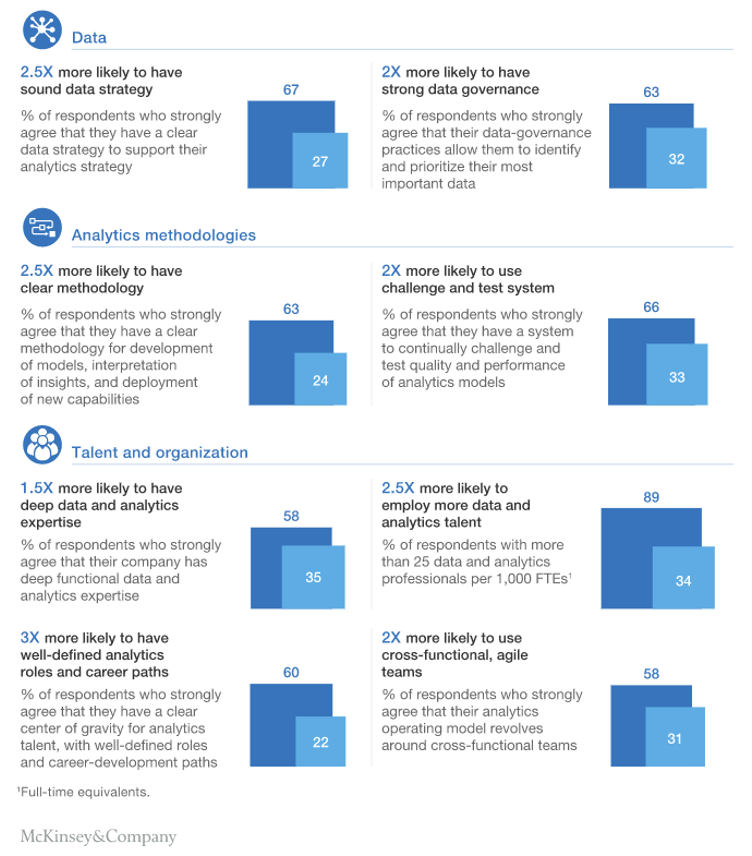

Un estudio de McKinsey señala que solo el 30% de las transformaciones empresariales logran cumplir con sus objetivos completos. (McKinsey & Company, 2021). Esta cifra pone de manifiesto una realidad alarmante: el éxito técnico y estratégico no garantiza el éxito organizacional.

La gestión del cambio actúa como un puente entre la solución y su implementación efectiva. Sin este puente, las iniciativas quedan en ideas que no logran materializarse en resultados tangibles.

¿Por qué fallan los proyectos?

En el contexto de proyectos de gobierno del dato, la gestión del cambio cobra una importancia aún mayor. Estas iniciativas no solo implican la implementación de nuevas herramientas o la definición de procesos, sino que también exigen una transformación cultural dentro de la organización.

Crear una cultura de datos, donde cada miembro de la empresa valore y utilice los datos como un activo estratégico, requiere tiempo, esfuerzo y, sobre todo, una estrategia sólida de cambio organizacional.

Muchos líderes se centran exclusivamente en los aspectos técnicos del proyecto, olvidando que el verdadero reto radica en cambiar comportamientos, hábitos y formas de trabajo consolidadas.

Claves para una gestión del cambio efectiva

- Comunicación constante: Las personas necesitan entender el «por qué» detrás del cambio. Una comunicación clara y consistente es crucial para reducir incertidumbres y ganar aceptación.

- Liderazgo visible: Los líderes deben ser los primeros en adoptar y promover el cambio. Su compromiso es un factor motivador para el resto de la organización.

- Formación y soporte: Implementar cambios sin capacitar a las personas genera frustración. Proveer las herramientas y el conocimiento necesario es clave.

- Medición y ajustes: Evaluar constantemente cómo se está desarrollando la transición permite corregir errores y ajustar la estrategia según sea necesario.

El éxito de un proyecto no radica solo en la calidad de su planificación o en el presupuesto invertido, sino en su capacidad para transformar a las personas y las organizaciones.

La gestión del cambio no es un complemento, es el núcleo que conecta la innovación con el impacto real.

Por ello, debemos abordarla con la misma rigurosidad y atención que cualquier otra fase del proyecto.

Como profesionales, tenemos la responsabilidad de no solo diseñar grandes soluciones, sino también de asegurarnos de que estas soluciones encuentren un lugar en las dinámicas diarias de las personas.

Solo así lograremos que nuestras ideas no se queden en el papel, sino que se conviertan en auténticos motores de cambio.

- Comunicación constante: Las personas necesitan entender el "por qué" detrás del cambio. Una comunicación clara y consistente es crucial para reducir incertidumbres y ganar aceptación.

- Liderazgo visible: Los líderes deben ser los primeros en adoptar y promover el cambio. Su compromiso es un factor motivador para el resto de la organización.

- Formación y soporte: Implementar cambios sin capacitar a las personas genera frustración. Proveer las herramientas y el conocimiento necesario es clave.

- Medición y ajustes: Evaluar constantemente cómo se está desarrollando la transición permite corregir errores y ajustar la estrategia según sea necesario.

El éxito de un proyecto no radica solo en la calidad de su planificación o en el presupuesto invertido, sino en su capacidad para transformar a las personas y las organizaciones.

La gestión del cambio no es un complemento, es el núcleo que conecta la innovación con el impacto real.

Por ello, debemos abordarla con la misma rigurosidad y atención que cualquier otra fase del proyecto.

Como profesionales, tenemos la responsabilidad de no solo diseñar grandes soluciones, sino también de asegurarnos de que estas soluciones encuentren un lugar en las dinámicas diarias de las personas.

Solo así lograremos que nuestras ideas no se queden en el papel, sino que se conviertan en auténticos motores de cambio.